Proxmox VE Clustering Best Practice

Published on January 25, 2025

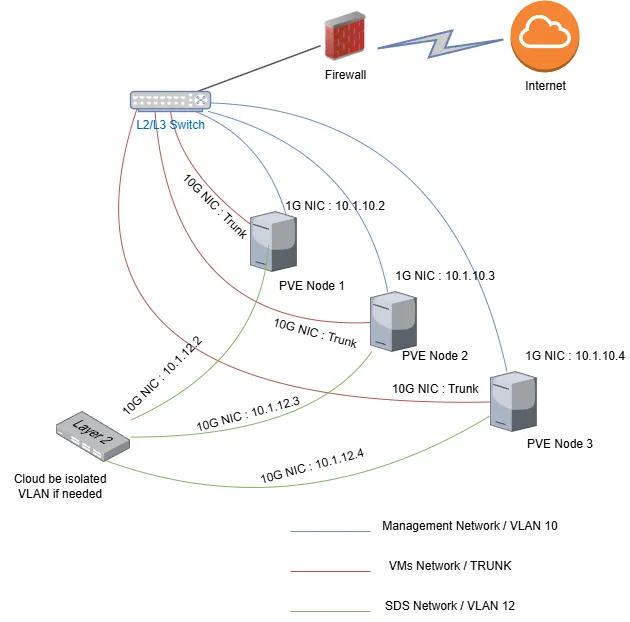

แนวทาง Best Practice สำหรับการติดตั้ง Proxmox VE Cluster ด้วย NIC แยกตามการใช้งาน

การแยก NIC ออกจากกันใน Proxmox VE Cluster เป็นแนวทาง Best Practice ที่ช่วยเพิ่มประสิทธิภาพ, ความปลอดภัย, และความเสถียรของระบบ โดยเฉพาะเมื่อใช้งานร่วมกับ Ceph Storage (Software Defined Storage) ภายใน Cluster นี่คือเหตุผลหลักที่ควรแยกแต่ละ NIC ออกจากกัน

1. ปรับปรุงประสิทธิภาพเครือข่าย (Performance Optimization)

การรวมทุกอย่างไว้บน NIC เดียวอาจทำให้เกิด Network Bottleneck เพราะอย่าลืมว่า การสำรองข้อมูลนั้น data จะวิ่งผ่าน Management Network และหากทราฟฟิกของ Management, VM, และ Storage จะต้องใช้แบนด์วิดท์ร่วมกันโอกาศจะเกิดคอขวดจะเพิ่มขึ้นอย่างมาก ประโยชน์ที่ได้จากการแยก Physical NIC ออกจากกัน:

– Management Traffic มีเสถียรภาพ ไม่ถูกแบนด์วิดท์ของ VM หรือ Storage รบกวน การสำรองข้อมูลเป็นอิสระ

– VM Traffic ทำงานได้อย่างเต็มประสิทธิภาพ โดยไม่ต้องแชร์กับทราฟฟิก Ceph หรือ Management

– Ceph Storage Traffic ไม่สร้างภาระให้กับ NIC อื่น ๆ ช่วยลด Latency ในการอ่าน-เขียนข้อมูล

2. ลด Latency และเพิ่มความเร็วในการเข้าถึงข้อมูล (Low Latency & High Throughput)

Ceph Storage ต้องการเครือข่ายที่มี Latency ต่ำและ Throughput สูง การใช้ 10Gbps NIC สำหรับ Ceph ทำให้สามารถ Replica และ Recovery ได้เร็วขึ้น

เครือข่ายที่ใช้แชร์ระหว่าง VM และ Storage อาจเกิดปัญหา Congestion ได้ แต่ถ้าแยก Ceph ออกไป ระบบ VM จะไม่ถูกผลกระทบ

3. ป้องกันปัญหาคอขวดของเครือข่าย (Network Bottleneck Prevention)

หาก VM, Ceph, และ Management ใช้ NIC เดียวกัน อาจเกิดปัญหาต่อไปนี้:

– Management Interface อาจไม่ตอบสนอง ในกรณีที่มีทราฟฟิก Ceph หรือ VM สูง

– Ceph Storage อาจมี Latency สูง หากต้องแข่งกับทราฟฟิกของ VM

– การแยก NIC ช่วยให้แต่ละเครือข่ายทำงานได้เต็มที่ ไม่แย่งทรัพยากรกัน

4. เพิ่มความปลอดภัย (Security Enhancement)

การมี Dedicated Management NIC (1Gbps) แยกจากเครือข่าย VM และ Storage ช่วยลดความเสี่ยงด้าน Security เช่น:

– ป้องกันการโจมตีจาก VM ไปยังโครงสร้างพื้นฐานของ Cluster

– จำกัดสิทธิ์ของผู้ใช้ให้เข้าถึงเฉพาะ Management Network

– ลดโอกาสที่มัลแวร์หรือการโจมตีเครือข่ายจาก VM จะกระทบกับ Ceph หรือ Proxmox Cluster

ทั้งนี้ต้องอย่าลืมว่า Management Network และ/หรือ SDS นั้นไม่จำเป็นจะต้องเป็นเน็ตเวิร์กที่ออกเน็ตได้เลย

5. ป้องกัน Downtime และเพิ่มความสามารถในการรองรับความเสียหาย (High Availability & Redundancy)

หากมี NIC หรือ Switch ใดเสีย การแยกเครือข่ายออกจากกันจะช่วยลดผลกระทบ

ตัวอย่างเช่น ถ้า VM Traffic ใช้ 10Gbps NIC และเกิดปัญหา แต่ Management NIC (1Gbps) ยังทำงานได้ เราจะยังสามารถบริหารจัดการ Cluster ได้

สรุปแนวทาง Best Practice

– แยกเครือข่ายตามประเภทของทราฟฟิก

– ใช้ NIC ความเร็วสูง (10Gbps) สำหรับ Ceph และ VM

– ใช้ NIC 1Gbps แยกสำหรับการจัดการ (Management)

– ลด Bottleneck และ Latency ของเครือข่าย

– เพิ่มความปลอดภัยและลดความเสี่ยงจากการโจมตีเครือข่าย

– เพิ่มเสถียรภาพและความสามารถในการรองรับความเสียหายของ Cluster

การออกแบบเครือข่ายแบบนี้จะช่วยให้ Proxmox VE Cluster ทำงานได้อย่างเต็มประสิทธิภาพและปลอดภัยมากขึ้น เลือกการติดตั้ง Proxmox VE นั้นต้องทำโดยผู้ที่รู้จักเท่านั้น หากท่านต้องการ ที่ปรึกษา ซื้อซอฟต์แวร์ และ ติดตั้ง ติดต่อเราได้เพื่อรับคำปรึกษาฟรี email : [email protected] / LINE OA : @avesta.co.th หรือโทร 045-959612

บริษัท อเวสต้า จำกัด จำหน่าย ติดตั้ง ออกแบบระบบ virtualization ครบวงจร ด้วยประสบการณ์รนับ 10 ปี ให้บริการลูกค้ารายใหญ่น้อยทั่วไทย

วันสิ้นสุด License Perpetual ของ VMware มาถึงแล้ว รีบย้ายไป Proxmox VE กันเถอะ

Garage ทางเลือกในการแทนที่ MinIO

Time Range Booking System

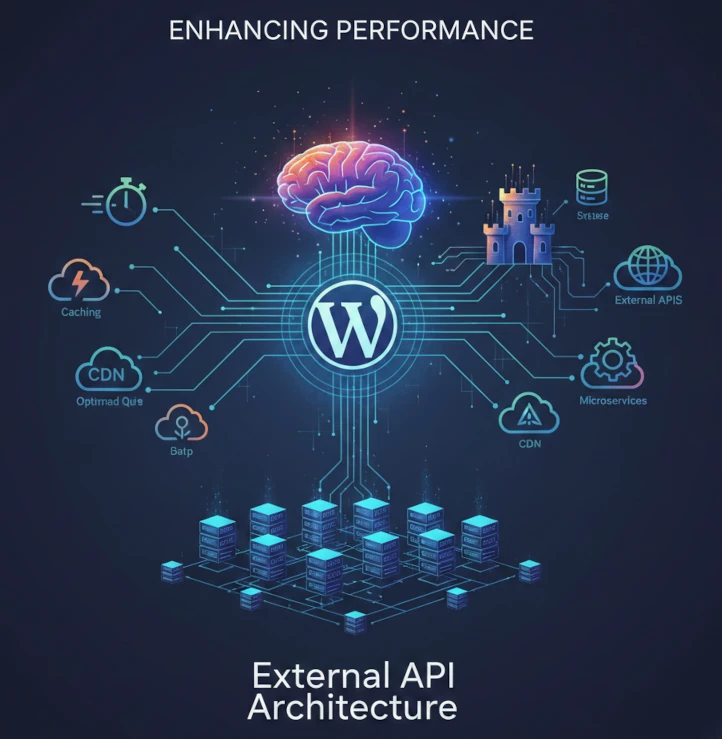

เพิ่มขีดความสามารถของ WordPress ด้วยการเชื่อมต่อ External API

Private Branding Hotel/Property Reservation System